国产AI一夜刷屏海外,2000 块GPU打造GPT-4o平替,AI大佬纷纷点赞

一 夜之间,中国大模型在国际上狠狠秀了一波肌肉。

近日,国产大模型厂商 DeepSeek 宣布 DeepSeek-V3 首个版本上线并同步开源。

多项基准测试成绩显示,DeepSeek-V3 超越 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上与 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

一手技术报告中提到,该模型的预训练阶段也就 用 2048 块 GPU 训练了 2 个月,并且只花费了 557.6 万美元。

低成本创造高价值。

堪称 国货之光的 DeepSeek-V3 更是直接 炸出了一大堆海外专业 AI 人士的背书。

醒醒,Deepseek,你现在是真的火了。

附上体验地址:chat.deepseek.com

DeepSeek-V3 上手实测,这次真的不一样

先来看看 DeepSeek 官方交出的亮眼成绩单:

百科知识:DeepSeek-V3 在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5 显著提升,接近当前表现最好的模型 Claude-3.5-Sonnet-1022。

长文本:在长文本测评中,DROP、FRAMES 和 LongBench v2 上,DeepSeek-V3 平均表现超越其他模型。

代码:DeepSeek-V3 在算法类代码场景(Codeforces),远远领先于市面上已有的全部非 o1 类模型;并在工程类代码场景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。

数学:在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上,DeepSeek-V3 大幅超过了所有开源闭源模型。

中文能力:DeepSeek-V3 与 Qwen2.5-72B 在教育类测评 C-Eval 和代词消歧等评测集上表现相近,但在事实知识 C-SimpleQA 上更为领先。

DeepSeek-V3 发布之后,瞬间在海内外引起了巨大的反响。

前 Google Search 成员 Deedy 直接放话,DeepSeek V3 代表了全球最强的开源大模型,没跑了。

DeepS eek-V3 的高效益也得到了前 OpenAI 大神 Andrej Karpathy 的盖章印证:

「(DeepSeek)这是否意味着开发前沿级 LLM 不需要大型 GPU 集群?并非如此,但你必须确保对资源的高效利用。这次的成果是一个很好的例证,说明在数据和算法方面仍有大量优化空间可以挖掘。」

Meta AI 研究科学家田渊栋兴奋地连发两条推文:

「阅读报告,发现他们从零开始对 H800 进行的惊人破解 🤯

FP8 预训练、MoE、在非常有限的预算下实现强劲性能、通过 CoT 蒸馏进行引导启动……哇,这真是了不起的工作 👏👏 👍👍」

X 网友 Tom Dörr 玩了一圈后直呼 Deepseek V3 太聪明了,甚至不需要解释就懂我在说啥,感觉 机器里藏个鬼似的 」

别急,还有高手。

有网友直接将 4/8个M4 Mac mini 堆叠在一起来跑 DeepSeek-V3。还有开发者使用 DeepSeek-V3 三下五除二就做出了一个小游戏。

对比国外的 ChatGPT、Claude 之流, DeepSeek-V3 人人免费,且国内现在就能用。 我已经替大 伙简单上手体验了。

真的, DeepSeek-V3 响应速度之快还是出乎我的意料。

前代 v2.5 版本每秒能生成 20 个 token(可以理解为差不多 7-8 个汉字),而新版本 v3 直接提速到每秒 60 个 token,速度直接飙升到了原来的 3 倍。

打个比方,v2.5 就像是正常人说话的节奏,而 v3 的速度已经像是一个训练有声的播音员在快速播报了。

不过, DeepSeek-V3 并不支持多模态输入输出,估计还得再耐心等待。 而 体验下来, 「 9.8 和 9.11 哪个大 」和 「 strawberry 里有多少个 r 」已经难不倒它了。

继续上点强度。

「 我有 6 个鸡蛋,碎了 2 个,煎了 2 个,吃了 2 个,还剩下几个? 」

DeepSeek-V3 快是快了,但还是掉进了脑筋急转弯的陷阱(2 个),而 GPT-4o 则成功作答(4 个),这一回合,GPT-4o 完胜。

最近情商测试题在 X 平台很火,我们也试了试。

看得出来,GPT-4o 和 DeepSeek-V3 似乎 都很喜欢「42」这个数字。

很好,逻辑题也都没有绕晕 GPT-4o 和 DeepSeek-V3。

「如果明天是晴天,那么我今天会去郊外露营,如果我今天去郊外露营,那么明天一定是晴天吗?」

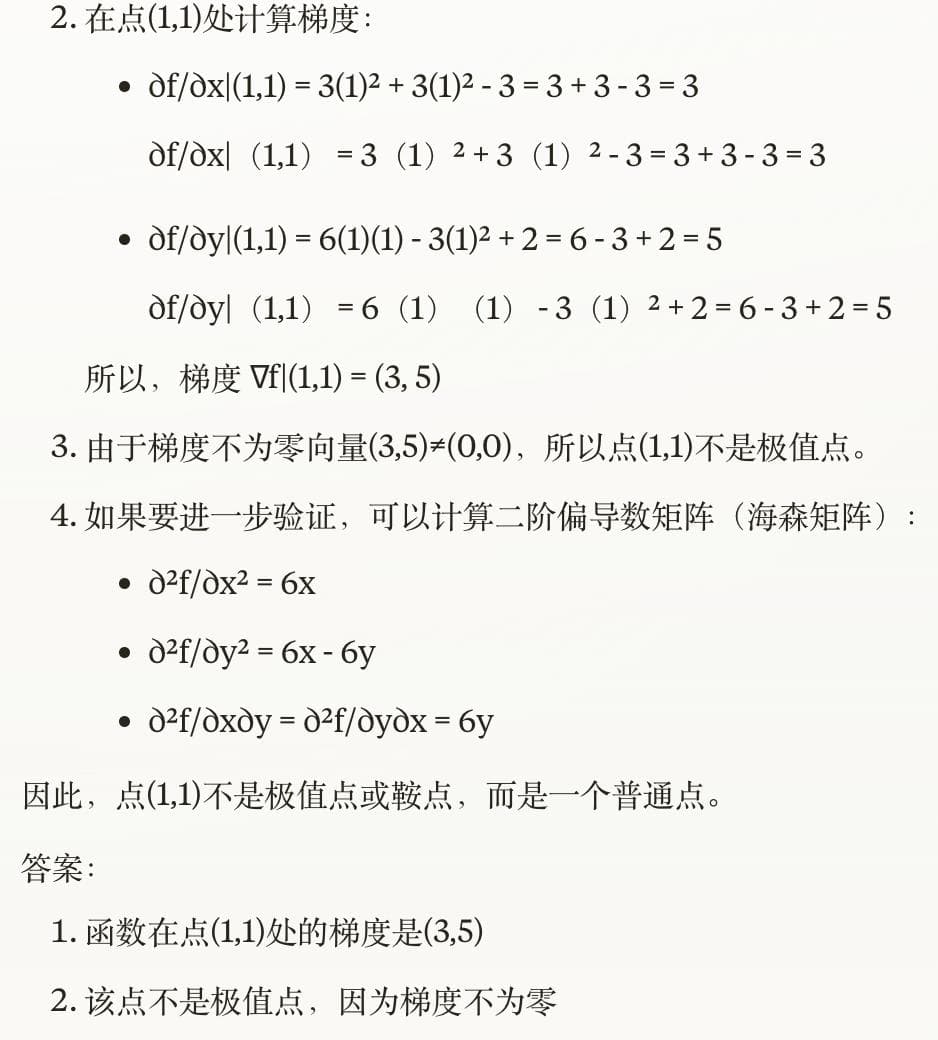

至于 DeepSeek-V3 会不会偏科,我们也试着让 GPT-4o 给它以及 Claude-3.5-Sonnet 出一道数学题。

「设函数 f ( x , y ) = x 3 + 3 x y 2 − 3 x − y 3 + 2 y f(x,y)=x3+3xy2−3x−y3+2y。求函数在点 ( 1 , 1 ) (1,1) 处的梯度,并判断该点是否为极值点,若是极值点,请判断其为极大值点、极小值点还是鞍点。」

片刻之后,DeepSeek-V3 以及 Claude-3.5-Sonnet 分别给出了各自的答案。

谁说 AI 只能烧钱,DeepSeek-V3 究竟做对了什么?

翻开 DeepSeek-V3 的技术报告,我通篇只看到了创新二字。

DeepSeek-V3 为自研 MoE 模型,671B 参数,激活 37B,在 14.8T token 上进行了预训练。

MoE 架构不难理解, 就像一个公司有不同部门的专家(如财务、技术、市场等), 每个专家都精通自己的领域,但不需要处理所有工作。

MoE 模型中的每个「专家」也是如此,专门处理特定类型的任务,遇上任务时,能够智能地调动最合适的专家来解决特定问题。

基于其前身 DeepSeek-V2 的高效性,该模型集成了多头潜在注意力(Multi-head Latent Attention, MLA)和 DeepSeekMoE 架构,从而实现了高效推理和成本优化的训练。

报告中还提到 DeepSeek-V3 引入了两个关键创新。

一种无需辅助损失的负载平衡策略,以及一种多 Token 预测(Multi-Token Prediction, MTP)的训练目标。

两千块 GPU,两个月时间,DeepSeek 用最优雅的方式证明了技术创新的重要性。

具体而言,该模型在 14.8 万亿多样且高质量的 Token 上完成预训练, 随后通过监督微调(SFT)和强化学习(RL)阶段进一步优化性能。

预训练阶段在 2048 个 H800 GPU 的集群上耗时不到两个月,总计 266.4 万个 GPU 小时。

通过优化算法、框架与硬件的协同设计,DeepSeek-V3 的总训练成本为 557.6 万美元,并且 这一成本还包括预训练、上下文长度扩展及后续训练阶段。

技术报告的贡献与致谢名单,清一色中文姓名

更多细节欢迎查询技术报告:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

对于开发者而言,DeepSeek-V3 API 服务定价也将调整为每百万输入 tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元。

更重要的是, 追求普惠 AGI 的 DeepSee k 率先开放了采用 FP8 训练的 DeepSeek-V3 原生权重。

得益于开源社区的支持,SGLang 和 LMDeploy 已经第一时间支持了 V3 模型的原生 FP8 推理,同时 TensorRT-LLM 和 MindIE 则实现了 BF16 推理。

此外,为方便社区适配和拓展应用场景, DeepSeek 官方还提供了从 FP8 到 BF16 的转换脚本。

模型权重下载和更多本地部署信息请参考:https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

可以说,今年的圣诞老人来自中国的 DeepSeek。

而这份源自中国的圣诞礼物,让全球见证了 AI 的中国速度。

海外有 Meta,中国有 DeepSeek、智谱、面壁等国产厂商, 中国 在 开源社区的 存在感也因此在不断攀升。

更多的厂商为中国开源盛世倾注一份心力的同时, 也是在呼吁这种纯粹和利他性的回归。

如果说今天凌晨 ChatGPT 的再度宕机提醒我们 AI 模型多元化的重要性,那么下一次,我们将多出一个可靠的选择。

那就是来自中国的 DeepSeek-V3。

One more thing

最近,ChatGPT o3 聊天记录编造器爆火,我们也跟风生成了一个聊天界面。

o3 都这么说了,这下真不能不信了(手动狗头)。

附上体验地址:https://chatgpt-meme-generator.vercel.app/

本文来自微信公众号“APPSO”